Red Hat AI

Red Hat® AI accelera l'adozione dell'IA di livello enterprise grazie a modelli piccoli e progettati per le aziende, tecniche di personalizzazione efficienti e la possibilità di sviluppare e distribuire le soluzioni in qualsiasi ambiente.

Red Hat AI può aiutarti ad adottare l'IA o ad ampliarne il suo utilizzo.

Soluzioni Red Hat AI

Red Hat Enterprise Linux® AI

Red Hat Enterprise Linux AI è un'ottima soluzione per le aziende che iniziano a utilizzare l'IA e devono ancora definirne gli scenari di utilizzo. Questa piattaforma è progettata per sviluppare, testare ed eseguire i modelli fondativi dell'IA generativa (IA gen).

Caratteristiche e vantaggi

Include gli LLM della famiglia Granite di IBM

Modelli perfezionati a livello locale con InstructLab

Costi convenienti per i clienti con accesso ristretto alle GPU

Red Hat OpenShift® AI

Red Hat OpenShift AI è progettato per i clienti pronti ad ampliare le applicazioni basate sull'IA. Questa piattaforma aiuta a gestire il ciclo di vita dei modelli di IA predittiva e generativa negli ambienti di cloud ibrido.

Caratteristiche e vantaggi

Funzionalità MLOps di livello enterprise

Include i modelli LLM Granite di IBM e gli strumenti InstructLab

Consente di creare e distribuire su larga scala soluzioni di IA con acceleratori hardware e supporto per il cloud ibrido.

Cos'è InstructLab?

InstructLab di Red Hat è un progetto promosso dalla community che consente agli sviluppatori (a prescindere dal livello di esperienza con il machine learning) di testare più agevolmente i modelli Granite di IBM.

È un ottimo punto di partenza per provare il modello di IA che preferisci o eseguire il fine tuning dei modelli fondativi presenti nel tuo hardware locale.

In questo modo puoi ridurre le risorse e i costi necessari per sperimentare i modelli di IA prima di adottare questa tecnologia a livello aziendale.

Partner Red Hat AI

Più numerosi sono i partner, più aumentano le opzioni a disposizione dei clienti.

Con le giuste tecnologie e il supporto degli esperti del settore, i nostri clienti potranno sfruttare al massimo il potenziale dell'IA. Molti partner tecnologici collaborano con Red Hat per certificare la compatibilità dei propri prodotti con le nostre soluzioni, e così il nostro ecosistema continua a crescere.

Analisi della soluzione

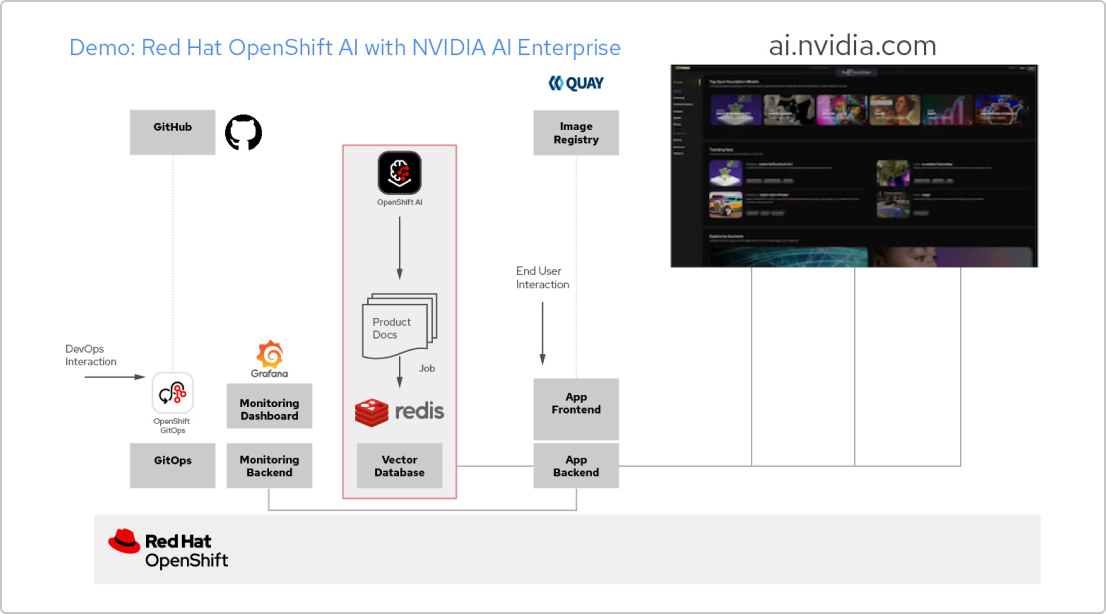

Applicazioni IA con Red Hat e NVIDIA AI Enterprise

Crea un'applicazione RAG

Red Hat OpenShift AI è una piattaforma per creare progetti di data science e distribuire applicazioni abilitate all'IA. Puoi integrare tutti gli strumenti che ti servono per supportare la tecnologia retrieval augmented generation (RAG), un metodo per ottenere le risposte dell'IA dai tuoi documenti di riferimento. Quando connetti OpenShift AI con NVIDIA AI Enterprise, puoi fare alcune prove con gli LLM (Large Language Model) per trovare il modello ideale per la tua applicazione.

Sviluppa una pipeline per i documenti

Se vuoi usare la tecnologia RAG, per prima cosa devi inserire i tuoi documenti in un database vettore. Nella nostra app di esempio, integriamo una serie di documenti di prodotto in un database Redis. Visto che questi documenti vengono modificati spesso, possiamo creare una pipeline da eseguire periodicamente per tale processo in modo da disporre sempre della versione più recente.

Sfoglia il catalogo degli LLM

NVIDIA AI Enterprise ti offre l'accesso a un catalogo di diversi modelli LLM, così potrai fare diverse prove e scegliere quello che offre risultati migliori. I modelli sono ospitati nel catalogo delle API di NVIDIA. Una volta che hai impostato un token API, puoi eseguire il deployment di un modello utilizzando la piattaforma di distribuzione dei modelli NVIDIA NIM direttamente da OpenShift AI.

Scegli il modello giusto

Mentre fai alcune prove con i diversi modelli LLM, i tuoi utenti possono valutare ogni risposta generata. Puoi configurare una dashboard di monitoraggio Grafana per confrontare le valutazioni, oltre che i tempi di risposta e di latenza di ogni modello. Potrai quindi sfruttare questi dati per scegliere il miglior modello LLM da usare nel tuo ambiente di produzione.

Storie di successo di Red Hat AI

Ortec Finance accelera la crescita e i tempi di rilascio

Ortec Finance, provider globale di soluzioni tecnologiche per la gestione di rischi e rendimenti, eroga modelli di machine learning su Microsoft Azure Red Hat OpenShift e ha deciso di adottare Red Hat AI.

Boston University realizza una piattaforma educativa

La Boston University ha creato un ambiente di apprendimento scalabile che accoglie centinaia di utenti di informatica e ingegneria informatica.