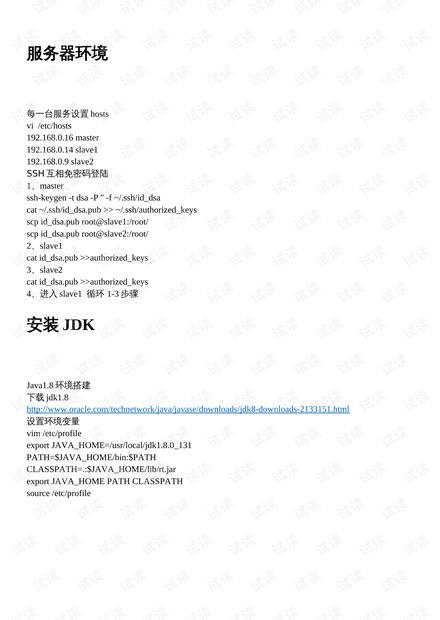

### Scala Hadoop Spark 服务器环境部署详解 #### 一、概述 在大数据处理领域,Apache Hadoop、Apache Spark以及Scala是三个重要的技术组件。本文旨在详细介绍如何在服务器上搭建一个包含Scala、Hadoop与Spark的完全分布式环境。通过本指南,您将能够成功地在多台服务器之间配置这些组件,并实现数据的高效处理。 #### 二、环境准备 **1. 主机配置** - **主机IP分配:** - Master: 192.168.0.16 - Slave1: 192.168.0.14 - Slave2: 192.168.0.9 **2. hosts文件配置** - 在每台服务器上编辑`/etc/hosts`文件,确保正确的域名与IP地址映射,例如: ```bash vi /etc/hosts 192.168.0.16 master 192.168.0.14 slave1 192.168.0.9 slave2 ``` **3. SSH无密码登录** - 在Master节点上生成SSH密钥: ```bash ssh-keygen -t dsa -P '' -f ~/.ssh/id_dsa ``` - 将公钥复制到每个节点: ```bash cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys scp id_dsa.pub root@slave1:/root/ scp id_dsa.pub root@slave2:/root/ ``` - 在Slave1和Slave2节点上,将公钥添加到`authorized_keys`文件: ```bash cat id_dsa.pub >> authorized_keys ``` **4. 重复上述步骤以确保所有节点之间都能进行SSH无密码登录。** #### 三、JDK安装 **1. 下载JDK** - 从Oracle官网下载JDK 1.8: - 下载地址: [http://www.oracle.com/technetwork/java/javase/downloads/jdk8-downloads-2133151.html](http://www.oracle.com/technetwork/java/javase/downloads/jdk8-downloads-2133151.html) **2. 设置环境变量** - 编辑`/etc/profile`文件并添加以下内容: ```bash export JAVA_HOME=/usr/local/jdk1.8.0_131 PATH=$JAVA_HOME/bin:$PATH CLASSPATH=.:$JAVA_HOME/lib/rt.jar export JAVA_HOME PATH CLASSPATH ``` - 执行`source /etc/profile`使配置生效。 #### 四、Scala 2.12.4 安装 **1. 下载Scala安装包** - 使用wget命令下载Scala 2.12.4的rpm安装包: ```bash wget https://downloads.lightbend.com/scala/2.12.4/scala-2.12.4.rpm rpm -ivh scala-2.12.4.rpm ``` **2. 添加Scala环境变量** - 同样在`/etc/profile`中添加Scala环境变量: ```bash export SCALA_HOME=/usr/share/scala export PATH=$SCALA_HOME/bin:$PATH ``` #### 五、Hadoop 2.7.4 分布式搭建 **1. 下载Hadoop安装包** - 使用wget命令下载Hadoop 2.7.4: ```bash wget http://www-eu.apache.org/dist/hadoop/common/hadoop-2.7.4/hadoop-2.7.4.tar.gz ``` **2. 解压缩并移动** - 将解压缩后的文件移动到指定目录,例如`/opt`: ```bash tar -zxvf hadoop-2.7.4.tar.gz mv hadoop-2.7.4/ ctdata ``` **3. 配置环境变量** - 在`/etc/profile`中添加Hadoop环境变量: ```bash export HADOOP_HOME=/ctdata/hadoop-2.7.4/ export PATH=$PATH:$HADOOP_HOME/bin export PATH=$PATH:$HADOOP_HOME/sbin export HADOOP_MAPRED_HOME=$HADOOP_HOME export HADOOP_COMMON_HOME=$HADOOP_HOME export HADOOP_HDFS_HOME=$HADOOP_HOME export YARN_HOME=$HADOOP_HOME export HADOOP_ROOT_LOGGER=INFO,console export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native export HADOOP_OPTS="-Djava.library.path=$HADOOP_HOME/lib:$HADOOP_COMMON_LIB_NATIVE_DIR" ``` **4. 修改配置文件** - 配置`/ctdata/hadoop-2.7.4/etc/hadoop/hadoop-env.sh`中的`JAVA_HOME`路径: ```bash export JAVA_HOME=/usr/local/jdk1.8.0_121 ``` - 修改`/ctdata/hadoop-2.7.4/etc/hadoop/slaves`文件: ```bash slave1 slave2 ``` - 配置`/ctdata/hadoop-2.7.4/etc/hadoop/core-site.xml`文件: ```xml <configuration> <property> <name>fs.defaultFS</name> <value>hdfs://master:9000</value> </property> <property> <name>io.file.buffer.size</name> <value>131072</value> </property> </configuration> ``` #### 六、Spark 2.1.0 安装与配置 **1. 下载Spark** - 从Apache Spark官方网站下载Spark 2.1.0安装包。 **2. 解压Spark** - 将下载好的Spark安装包解压到指定目录。 **3. 配置Spark** - 修改`spark-env.sh`文件,设置`SPARK_HOME`和`JAVA_HOME`等环境变量。 - 修改`spark-defaults.conf`文件,设置`spark.master`等参数。 **4. 启动Spark** - 在Master节点启动Spark集群。 #### 七、测试环境 - 运行简单的MapReduce任务或Spark应用程序来验证环境是否正确搭建。 #### 八、总结 通过以上步骤,我们成功地在服务器上搭建了一个包含Scala、Hadoop与Spark的完全分布式环境。这为后续的大数据处理任务奠定了坚实的基础。随着环境的成功部署,您可以开始探索更多的大数据应用场景和技术栈了。

剩余8页未读,继续阅读

- 粉丝: 0

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- UNET人脸嘴唇分割-毕业设计资源

- Mathematical_Contest_in_Modeling-美赛资源

- vcos_examples-智能车资源

- 蓝桥杯单片机真题代码-蓝桥杯资源

- 汇编语言-汇编语言资源

- J2Cache-Java资源

- JFinal-Python资源

- modelcontextprotocol_swift-sdk-Swift资源

- matlab-Matlab资源

- 2018 CCF大数据与计算智能大赛自动驾驶三维点云分割复赛第四方案

- Flet响应式行组件示例-图书管理系统响应式行布局自定义模板

- wukong-robot-机器人开发资源

- MXVideo-Kotlin资源

- nexfly-AI人工智能资源

- cpp-tbox-硬件开发资源

- 圣钰SAAS后台管理系统-当前系统只维护不升级.yubb-saas-pro商业版开发中-移动应用开发资源

信息提交成功

信息提交成功